Как GPT и голосовые ассистенты изменят работу со смартфонами

Блог компании Raft. Автор: Евгений Кокуйкин. В начале года мы уже стали свидетелями того, как AutoGPT, а затем GPT Engineer демонстрировали, что приложения на GPT способны совместно писать код и решать сложные задачи. Следующий этап — это автоматическое взаимодействие с приложениями с помощью голоса.

Сегодня мы рассмотрим свежую работу исследователей из Tencent, которые сделали прототип ассистента AppAgent для мобильных приложений. Этот ассистент способен учиться взаимодействовать с любыми приложениями, обеспечивая доступ к ним через голосовой интерфейс без необходимости интеграции с API или изменения пользовательского интерфейса.

Теперь достаточно сказать: “Эй, банк, переведи 300 рублей Васе за обед на карту Сбера”, и AppAgent самостоятельно откроет ваше любимое банковское приложение, найдет друга и переведет ему деньги. Конечно, возможно пока приложение учится, оно отправит не 300, а 3000 рублей, и не Васе, а Пете, но прогресс не остановить, и такое упрощение работы с девайсами наше будущее. Кстати, в статье утверждается, что на этапе прототипа уже достигнута точность (success rate) порядка 95%.

Добро пожаловать под КАТ за подробностями.

Подробнее о технологии

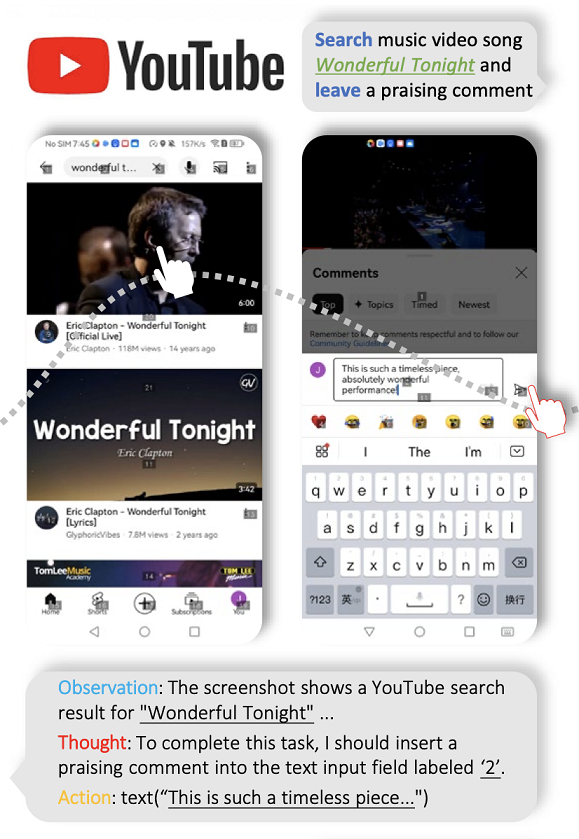

Спамим полезными комментами в соцсетях

Спамим полезными комментами в соцсетях

В проекте AppAgent: Multimodal Agents as Smartphone Users используется распознавание изображений через мультимодальную модель GPT-4V от OpenAI. То, что умный ассистент не привязан к определенным API, является его главным отличием от Siri и Алисы.

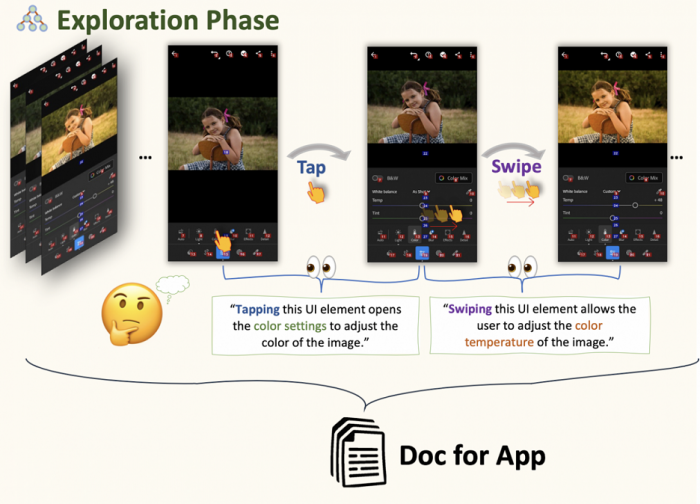

Во время фазы исследования (exploration phase), агент самостоятельно исследует приложение, пытаясь понять его функции и интерфейс. Параллельно, наблюдая за демонстрациями (watching demos), ассистент изучает типичные паттерны использования приложения людьми, что позволяет ему быстрее и эффективнее адаптироваться к новым задачам. Эти этапы, вместе взятые, формируют систему обучения, позволяющую AppAgent с высокой долей вероятности успешно выполнять задачи в различных приложениях.

Как это работает?

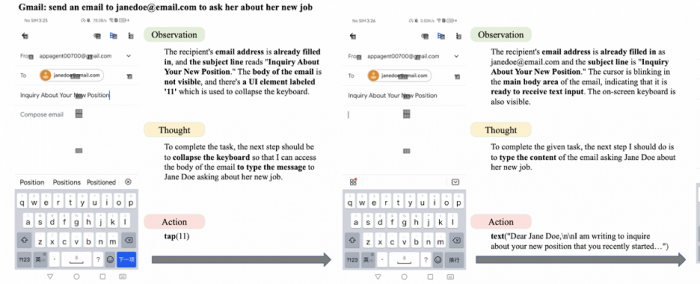

Цепочка «Посмотри-Подумай-Сделай»

Цепочка «Посмотри-Подумай-Сделай»

Приложение получает скриншоты интерфейса приложения и XML-файл с описанием интерактивных элементов других приложений(например, Youtube или Gmail на скриншоте выше). Каждому элементу присваивается уникальный идентификатор, что позволяет агенту точно взаимодействовать с ними, не определяя точные координаты на экране. Пространство действий включает общие человеческие взаимодействия с смартфонами: тапы, долгие нажатия, свайпы и ввод текста. Подобные решения уже существуют для написания автотестов на Selenium/Appium: GPT-4V может определить положение элементов на экране и при помощи естественного языка сделать клик или заполнить форму данными.

Этап исследования

В этой фазе агент учится функциональности и особенностям приложений через метод проб и ошибок.

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России