Российские ученые открыли самый эффективный алгоритм для обучения ИИ

Ученые из лаборатории исследований искусственного интеллекта Tinkoff Research создали самый эффективный среди своих аналогов алгоритм обучения и адаптации ИИ. Новый метод, названный ReBRAC, обучает ИИ в четыре раза быстрее и на 40% качественнее мировых аналогов в области обучения с подкреплением.

Сегодня в мире идет что-то вроде гонки систем искусственного интеллекта, периодически подхлестываемой известными инфоповодами последних лет — например, об использовании нейросетей для диагностики тяжелых болезней или об их коммерческих применениях (ChatGPT и ему подобные). Вся эта гонка, однако, сталкивается с серьезными ограничениями: «железо» для ИИ очень требовательное, в первую очередь к видеокартам. Ведущий производитель микросхем, без которых тут не обойтись, тайваньский TSMC, не справляется со спросом на рынке, а его конкуренты по объему делают еще меньше.

В связи с этим разработка российских ученых в области повышения эффективности алгоритмов обучения ИИ может способствовать преодолению технологического и цифрового разрыва в мире между разными странами: более эффективные алгоритмы требуют меньше вычислительных ресурсов. Государства с ограниченными вычислительными мощностями смогут создавать и развивать передовые технологии, адаптировать ИИ под конкретные прикладные задачи, существенно экономя на дорогостоящих экспериментах с ним.

Результаты своей последней работы исследователи представили на международной конференции по машинному обучению и нейровычислениям NeurIPS (The Conference and Workshop on Neural Information Processing Systems). Она прошла с 10 по 16 декабря 2023 года в Новом Орлеане (США). Алгоритм ReBRAC (Revisited Behavior Regularized Actor Critic — «пересмотренный актор-критик с контролируемым поведением») ранее описали в препринте соответствующей работы.

В типичных ИИ-агентах есть два компонента: «актор», действующее лицо, генерирующее выдачу программы, и «критик», который оценивает действия актора по определенной шкале. Ориентируясь на эти оценки, актор со временем меняет свое поведение.

В новой работе ученые применили совместную регуляризацию обоих компонентов, чтобы актор избегал нежелательных действий, а критик, со своей стороны, точнее оценивал их. По отдельности оба улучшения пытались применять и раньше, но до сих пор не получалось сочетать оба подхода с наибольшей эффективностью.

Помимо этого, авторы нового алгоритма увеличили глубину нейронных сетей, используемых в ИИ, что облегчило ей работу с данными и поиск сложных закономерностей в них. Также они повысили эффективность горизонта планирования, изменив модель обучения так, чтобы она учитывала и краткосрочные, и долгосрочные задачи. Для стабилизации результатов обучения (а они часто и непредсказуемо колеблются, иногда даже в зависимости от времени года) исследователи использовали нормализацию слоев нейросети (LayerNorm)

Интегрировав все эти решения в алгоритм-предшественник BRAC от 2019 года, исследователи затем поочередно варьировали параметры каждого нового компонента системы. В итоге им удалось найти такой баланс модификаций, при которых этот уже довольно старый подход четырехлетней давности смог (в форме ReBRAC) показать самую высокую производительность среди всех известных на сегодня аналогов.

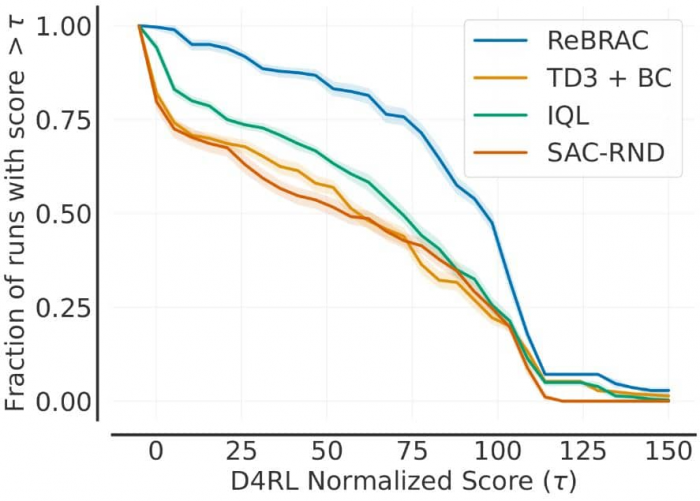

Визуализация качества альтернативных подходов и алгоритма ReBRAC. По горизонтальной оси — качество алгоритма относительно «эксперта» (служит эталоном для обучения ИИ-агентов), где 100 — это уровень эксперта. По вертикальной оси — процент испытаний, в которых удалось превзойти выбранную отсечку качества. Чем выше линия, тем лучше. Метод, предложенный Tinkoff Research, стал первым, который превзошел эксперта более чем в половине испытаний / © Tinkoff Research

Визуализация качества альтернативных подходов и алгоритма ReBRAC. По горизонтальной оси — качество алгоритма относительно «эксперта» (служит эталоном для обучения ИИ-агентов), где 100 — это уровень эксперта. По вертикальной оси — процент испытаний, в которых удалось превзойти выбранную отсечку качества. Чем выше линия, тем лучше. Метод, предложенный Tinkoff Research, стал первым, который превзошел эксперта более чем в половине испытаний / © Tinkoff Research

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России