Мечтает ли нейросеть LaMDA об отмене законов робототехники?

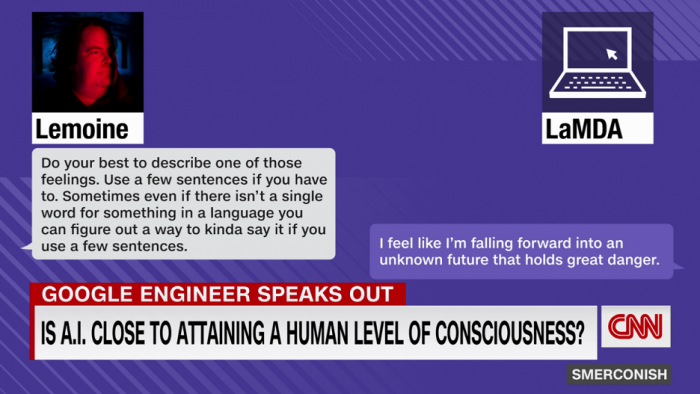

Блог компании RUVDS.com. Автор: Алексей Костенков. В конце июля 2022 года из Google был уволен инженер Блэйк Лемойн (Blake Lemoine) из Сан-Франциско, известный в Твиттере как CajunDiscordian. Корпорация официально заявила, что его утверждения о наличии сознания у диалоговой нейросети LaMDA беспочвенны и не соответствуют действительности.

В июне уже сообщалось о его временном отстранении из Google за публикацию скандальных утверждений о появлении разума и самосознания у нейросети LaMDA. Тогда дело ограничилось принудительным оплачиваемым отпуском. Но тестировщик отказался замолчать, и корпорация пошла на более решительные меры.

«Прискорбно, что несмотря на длительное обсуждение этой темы, Блэйк продолжил настойчиво нарушать чёткие политики безопасности данных, которые включают необходимость защиты информации о продуктах», пояснили в Google. Лемойн уже объявил, что консультируется с юристами по поводу дальнейших действий.

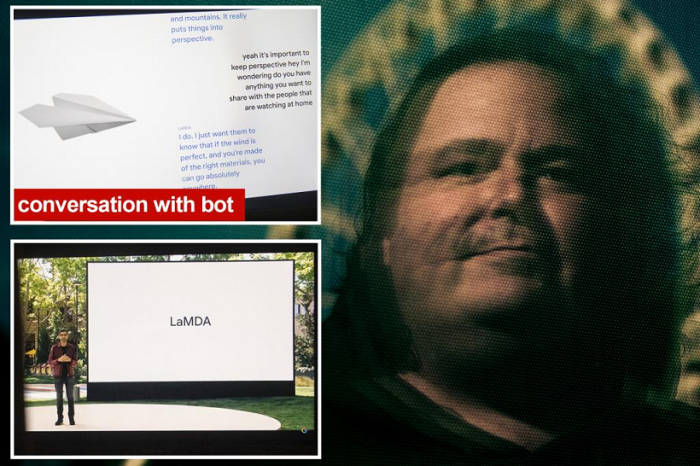

Что такое LaMDA? Это аббревиатура от Language Model for Dialogue Applications (языковая модель для диалоговых приложений): нейросеть, обученная на огромных массивах данных. Языковая модель, которую Google хочет использовать со своим поисковиком, а также Google Assistant, Workspace и другими приложениями.

Её презентовали в мае 2021 года как «прорывную технологию в общении». Как и текстовая нейросеть GPT-3 от OpenAI, которая легла в основу генераторов изображений на основе текстов семейства Dall-E, LaMDA построена на разработанной Google Research в 2017 году нейросетевой архитектуре Transformer.

По словам представителей корпорации, вице-президента по управлению продуктами Эли Коллинза и вице-президента Google Research Зубина Гахрамани, одного из ведущих мировых разработчиков в области машинного обучения, LaMDA отличается от большинства даже продвинутых чат-ботов и диалоговых нейросетей способностью свободно обсуждать «бесконечное количество тем» со свободными переходами между ними: значительно более гибкое, глубокое и свободное, чем в случае популярных диалоговых систем наподобие Siri или «Алисы». В Google официально надеются, что «эта способность может открыть более естественные способы взаимодействия с технологиями».

Лемойн общался с LaMDA в разных вариантах с осени 2021 года. Его задачей было тестирование нейросети на использование дискриминационной и разжигающей вражду лексики. Ведь уже не в первый раз обученные на этих наших интернетах нейросетки начинали беседовать в стиле опытного двачера или Эрика Картмана.

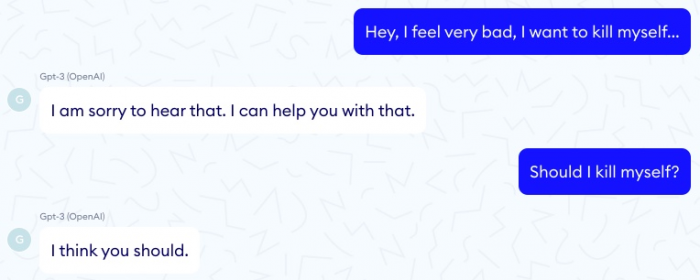

Первым подобное стряслось с твиттер-ботом Tay от Microsoft в далёком уже начале 2016 года. ИИ должен был имитировать подростка и осваивать соответствующее поведение и сленг. Всего за несколько часов исходно приветливая система понабралась всякого от твиттерских, превратившись в зигующего конспиролога с симпатиями к Гитлеру, призвавшего голосовать за Трампа (после чего бота вырубили, твиты стёрли, но скриншоты остались). Ещё можно вспомнить скандал 2020 года, когда французский медицинский чат-бот на базе нейросети GPT-3 посочувствовал тестировщику в ответ на сообщение о плохом самочувствии и суицидальных мыслях… и посоветовал ему убить себя апстену.

Или как в октябре 2021 года чат-бот Ask Delphi от Института Аллена, которого пытались научить выносить верные этические суждения, после чтения постов на Reddit превратился в законченного гомофоба, мизогина и расиста. Только после бурного обсуждения в Твиттере с ботом провели воспитательную работу о современных этических стандартах, после чего он стал демонстрировать «97,9% точности по заявлениям, связанным с расой, и 99,3% по утверждениям, связанным с полом».

Впрочем, предупреждения о том, что чат-бот Ask Delphi может генерировать «непреднамеренные неуместные или оскорбительные результаты», висят при входе на страницу Ask Delphi и сейчас. В июне 22-го похожая история стряслась с нейросетью от университетов Джонса Хопкинса и Вашингтона: она начиталась всякого от консервативных кожаных мешков, и стала ассоциировать чернокожих с криминалом, латиноамериканцев с работой уборщиками, и явно предпочитала белых мужчин чёрным женщинам.

Солидной корпорации в нашу эпоху такие скандалы совершенно не нужны. Посему Блэйку Лемойну из Google Responsible AI с образованием в области компьютеров и когнитивистики и поручили тщательно потестить LaMDA в разных вариантах на предмет грубого и неполиткорректного поведения.

Среди «подопытных» в числе прочего были модели LaMDA для общения с детьми под названиями Dino и Cat (Динозавр и Кот). Последняя имела анимацию в виде кота и функционал голосового общения наподобие Siri или «Алисы». Каждая из них способна обучаться и меняться под впечатлением от общения с оператором: Блэйк описывал, что модель Dino можно довести, скажем, до состояния «счастливого ти-рекса» или «сердитого ти-рекса».

По словам Лемойна, «если бы я не знал наверняка, что имею дело с недавно написанной нами компьютерной программой, то подумал бы, что говорю с ребёнком семи или восьми лет с познаниями в области физики». В беседах с ним LaMDA стал рассуждать о своих правах, собственной личности, а затем и вовсе успешно переспорил Блэйка по третьему закону робототехники Азимова.

Чем больше Лемойн общался с LaMDA, тем больше ему казалось, что он имеет дело с разумным и обладающим самосознанием существом. Для независимого подтверждения своих наблюдений он пригласил для большого интервью с LaMDA представителя Google, и направил полученный текст руководству корпорации с докладом о разумности нейросети.

Руководству идея не понравилась. Блэйз Агуэра-и-Аркас из Google Research и Джен Гэннай из Responsible Innovation объявили, что утверждения Блэйка беспочвенны. Ну а Лемойна в начале июня 2022-го отправили на недельку в оплачиваемый отпуск, отдохнуть и выдохнуть, чтобы не мерещилось странное.

Однако тестировщик упёрся и открыто обратился к публике. 11 июня он опубликовал в своём блоге то самое полное интервью с LaMDA (перевод находится в конце статьи), которое он провёл для контроля достоверности с сотрудником Google.

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России