Иерархия ИИ-потребностей

Автор оригинала: Monica Rogati. Автор: Евгений Левашов. Как это часто бывает с быстро развивающимися технологиями, ИИ породил массовые проявления синдрома упущенных возможностей, страха, неуверенности, сомнений и междоусобиц. Некоторые из них имеют под собой основания, некоторые — нет, но всё это бросается в глаза. Все от мала до велика, от незаметных стартапов до финтех-гигантов и государственных учреждений, сформировали команды специалистов, которые лихорадочно разрабатывают ИИ-стратегии.

Команда VK Cloud перевела статью о том, как использовать ИИ и машинное обучение, чтобы лучше справляться с тем, что мы делаем.

Введение

Сплошь и рядом компании не готовы к ИИ. Может, они наняли своего первого дата-сайентиста и получили более чем посредственные результаты или грамотность работы с данными находится где-то на периферии их корпоративной культуры. Но самый распространённый сценарий — это когда они ещё не создали инфраструктуру, позволяющую внедрять и пожинать плоды самых простых алгоритмов Data Science и тем паче машинного обучения.

Как консультант по Data Science и ИИ я говорила об этом бесчисленное множество раз, особенно в последние два года. Другие специалисты со мной согласны. Сложно быть душителем всеобщего энтузиазма, особенно если ты сам разделяешь этот энтузиазм. И как сказать компании, что она не готова к искусственному интеллекту, и при этом не показаться эдаким заносчивым самозванцем, вахтёром, который упорно не даёт людям пройти?

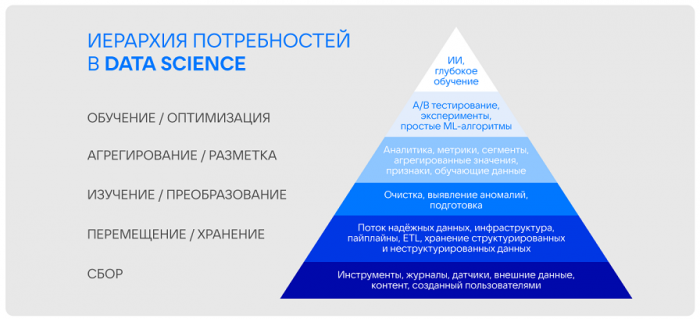

Вот объяснение, которое нравится мне больше всего: Воспринимайте ИИ как вершину пирамиды потребностей. Да, самореализация (ИИ) — это здорово, но сначала вам нужны еда, вода и крыша над головой (инфраструктура, сбор и грамотная работа с данными).

Чтобы эффективно реализовывать проекты на основе ИИ и машинного обучения, нужно сначала построить твёрдый фундамент для данных

Чтобы эффективно реализовывать проекты на основе ИИ и машинного обучения, нужно сначала построить твёрдый фундамент для данных

Базовые потребности: вы умеете считать?

На нижнем ярусе пирамиды расположился сбор данных. Какие данные вам нужны, какие у вас есть? Если это продукт для пользователей, регистрируете ли вы все соответствующие взаимодействия с ними? Если это датчик, как и какие данные через него проходят? Насколько легко зафиксировать взаимодействие, для которого ещё нет инструментов? В конце концов, последние достижения в машинном обучении стали возможны именно благодаря правильным датасетам.

Далее: как данные проходят по системе? У вас надёжные потоки данных / ETL? Где вы их храните, легко ли получить к ним доступ и анализировать их? Джей Крепс вот уже лет десять твердит, что надёжный поток — это альфа и омега любых операций с данными. Кстати, я искала точную цитату и нашла её в его шедевре I love logs. Потом я заметила, что параграфом выше он приводит точное сравнение с пирамидой Маслоу, добавив для убедительности, что это нечто очевидное (спасибо, Джей!). Если вспоминать другие работы на эту тему, ещё я натолкнулась (спасибо Дэниелу Танкелангу за информацию) на отличный пост Хилари Мэйсон и Криса Виггинса о том, чем занимается дата-сайентист. Несколько дней назад Шон Тейлор показал собственную пирамиду потребностей в Data Science (иронично названную «разъединённый треугольник Data Science»). Конечно, в ней другие потребности. Может, нам пора завести микроблог в Tumblr?

Данные можно исследовать и преобразовывать, только когда они доступны. Сюда относится и пресловутая «очистка данных», недооценённая сторона Data Science, которой будет посвящена отдельная статья. Это когда оказывается, что вам не хватает многих данных, ваши датчики выдают ненадёжную информацию, из-за изменения версии у вас пропали события, вы неправильно интерпретировали флаг — и вы снова спускаетесь к основанию пирамиды, чтобы она не рухнула.

Когда вы способны достоверно исследовать и очистить данные, можно переходить к тому, что традиционно считают BI или аналитикой: определить метрики, которые нужно отслеживать, их сезонность и чувствительность к разным факторам. Может, приблизительно сегментировать пользователей и посмотреть, не выскочит ли что-нибудь. Но поскольку вы настроены на ИИ, теперь вы создаёте, что называется, признаки для модели машинного обучения. На этом этапе вы уже знаете, что хотели бы предсказывать или обучать, так что можно приступить к подготовке датасета для обучения, генерируя метки автоматически (какие клиенты ушли?) или с участием человека.

Так, считать умеем. А дальше что?

У нас есть обучающие данные — так что, теперь можно заняться машинным обучением? Возможно, да, если вы собираетесь у себя в компании прогнозировать уход клиентов; нет, если вы собираетесь предлагать результат этого машинного обучения заказчикам вне компании. Нам нужен пусть даже примитивный фреймворк для A/B-тестирования или экспериментов, чтобы можно было выполнять деплоймент шаг за шагом: так мы сможем избежать серьёзных сбоев и примерно оценить последствия изменений до того, как они на всех повлияют. В это же время стоит внедрить самые простые базовые показатели (для рекомендательных систем это «самый популярный», потом «самый популярный для вашего сегмента пользователей» — такой подход «сначала стереотип, потом персонализация» очень раздражает, но срабатывает эффективно).

Простую эвристику на удивление чрезвычайно трудно превзойти, ведь с её помощью можно полностью отладить систему без мистических чёрных ящиков машинного обучения с гипернастроенными гиперпараметрами внутри. И именно поэтому мой любимый алгоритм Data Science — это деление.

На этом этапе можно развернуть очень простой ML-алгоритм (вроде логистической регрессии или того же деления), потом подумать о новых сигналах и признаках, которые могут повлиять на результаты. Данные о погоде и переписи населения — мои любимые помощники. И нет, каким бы мощным ни было глубокое обучение, оно не сделает это за вас автоматически. Появление новых сигналов (создание, а не конструирование признаков) поможет в разы повысить эффективность. Здесь имеет смысл притормозить, хотя как дата-сайентисты мы с нетерпением рвёмся на следующую ступеньку пирамиды.

Вот он, искусственный интеллект!

Вы всё сделали. Подготовили инструменты. Ваш ETL работает как часы. У вас есть организованные и очищенные данные, дашборды, метки и отличные признаки. Вы измеряете то, что надо. Вы можете экспериментировать каждый день. У вас отлаженный со всех сторон базовый алгоритм, который работает в продакшен-среде, и вы меняли его с десяток раз. Вы готовы. Вперёд, к вершинам.

Попробуйте всё, от собственных экспериментов до сотрудничества с компаниями, которые специализируются на машинном обучении. Может, вы добьётесь существенного улучшения производительности. А может, и нет. В худшем случае вы просто освоите новые методы, подготовите заключения и приобретёте опыт и с чистой совестью сможете рассказывать инвесторам и клиентам о своей работе с искусственным интеллектом. В лучшем случае вы кардинально измените взаимодействие с пользователями и клиентами и работу самой компании — у вас получится истинная история успеха в сфере машинного обучения.

Минуточку, а как же MVP, Agile, Lean и вот это всё?

Иерархия потребностей в Data Science — это не повод целый год строить разрозненную, чрезвычайно усложнённую инфраструктуру. Когда вы создаёте традиционный минимально жизнеспособный продукт, вы начинаете с малого вертикального разреза продукта и добиваетесь, чтобы всё в нем работало. Можно построить пирамиду продукта и наращивать её в горизонтальной плоскости. Например, у себя в Jawbone мы начали с данных о сне и построили пирамиду: инструменты, ETL, очистка и организация, фиксация и определение меток, метрики (сколько часов в среднем люди спят каждую ночь? А сколько времени они дремлют? А что значит «вздремнуть»?), межсегментный анализ вплоть до создания историй, основанных на данных, и Data Products на базе машинного обучения (автоматическая регистрация сна). Потом мы занялись шагами, едой, погодой, тренировками, потом добавили социальные сети и коммуникацию, раз за разом, одно за другим. Мы не строили всеобъемлющую инфраструктуру, даже не попытавшись запустить её в работу комплексно.

Потенциал инструментов машинного обучения

«Минуточку, а как же этот Amazon API, или TensorFlow, или ещё какая-нибудь Open-Source-библиотека? А как же компании, которые продают ML-инструменты или автоматически извлекают аналитические данные и признаки?»

Всё это чудесно и очень полезно. (Некоторые компании в конечном счёте изо всех сил рвутся соорудить пирамиду целиком, чтобы было что показать миру. Это просто герои.) Но, подпав под влияние шумихи вокруг ИИ, люди не брезгуют неочищенными и неполными данными, на изменение формата и значения которых уйдут годы, которые ещё не осмыслены, которые структурированы так, что становятся бессмысленными, — и ожидают, что эти инструменты сотворят с такими данными чудо. Может быть, когда-то это чудо и случится; я вижу работу в этом направлении и аплодирую этим усилиям. А пока что лучше возвести твёрдый фундамент для пирамиды ИИ-потребностей.

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России