Парадокс R2-D2: как человек влияет на искусственный интеллект

Блог компании Madrobots. Автор оригинала: Marc Bidan, Meriem Hizam. Группа исследователей искусственного интеллекта из Нантского университета озадачилась непростым вопросом. Является ли искусственный интеллект по-настоящему искусственным, или человеческий разум влияет на него больше, чем принято считать? Чтобы ответить на этот вопрос, они решили разобрать отношения Дарта Вейдера, Люка Скайуокера и робота R2-D2 из «Звездных войн».

Этот текст начинается с забавной истории. Или ошибки в хорошо прописанном сценарии. С парадокса, который вновь возвращает человеческий разум в центр того, что представляется — зачастую из-за неправильного использования слов — искусственным.

На этом парадоксе мы демонстрируем постоянное присутствие человеческого начала в искусственном интеллекте. Речь пойдет о несоответствии в позиции робота R2-D2 из космической саги «Звездные войны». Персонаж, с легкой руки сценаристов, всегда пребывал в здравой памяти. Но если RD-D2 никогда не страдал от амнезии, то почему не предупредил Люка Скайуокера о смертельной опасности, которую представлял его отец?

О каком парадоксе речь?

«Звездные войны», как и надлежит великому современному мифу, очаровывают нас соблазнительной непоследовательностью. Сага повествует о напряженных отношениях рыцаря-джедая Люка Скайуокера и его отца, Энакина Скайуокера, более известного как гениальный злодей Дарт Вейдер (о чем Люк не знал — прим.пер.). Именно в фильме 1980-го года «Империя наносит ответный удар» прозвучала знаменитая фраза «Люк, я твой отец». Ее говорит отец, Дарт Вейдер, своему сыну, Люку Скайуокеру, но в семейной сцене должен бы был участвовать вездесущий робот R2-D2.

Одна маленькая девочка несколько лет назад задала весьма колкий вопрос по этому поводу.

«R2-D2 присутствовал с самого начала истории, и его память никогда не стирали. Так почему робот просто не открыл Люку, что Вейдер был его отцом?»

Отец ребенка не нашелся, что ответить, а «просто стоял, ошеломленный, пожал плечами и ушел».

RD-D2 действительно посчастливилось постоянно полагаться на свои воспоминания, в то время как память его двуногого напарника, дроида C-3PO, была повреждена. Откуда у робота появились идея и возможность скрывать такую тайну? Почему милый и вездесущий робот не действовал в интересах своего хозяина, как полагается действовать правильному ИИ?

Как подойти к этому парадоксу?

В сети можно найти множество гипотез, объясняющих поведение R2-D2. Все они ведут к идее о некой его «человечности». Перечислим только 6 из них.

- Гипотеза 1: R2-D2 не хотел разбивать сердце Люка.

- Гипотеза 2: R2-D2 не мог предположить, что Люк был сыном его бывшего спутника-человека, поскольку фамилия «Скайуокер» часто встречается на его родной планете Татуин.

- Гипотеза 3: R2-D2 хотел, чтобы Люк сам узнал свою судьбу.

- Гипотеза 4: R2-D2 воздержался от того, чтобы неуклюже испортить реплику Дарта Вейдера.

- Гипотеза 5: R2-D2 очарован демоническим Дартом Вейдером и предпочитает его Люку, которого находит скучным.

- Гипотеза 6: Робота никто не спрашивал.

Во всех шести случаях R2-D2 ведет себя совершенно не так, как робот, чья миссия — защищать «хозяина».

Парадоксально, но наиболее вероятная версия — это оплошность сценаристов. Эта гипотеза еще и самая приятная: не бывает искусственного интеллекта без (ошибочного) человеческого вмешательства!

Нет интеллекта без обучения

Искусственный интеллект в том виде, в котором как мы его сейчас понимаем, учится, руководствуясь непосредственно логикой обучения людей. Но при этом он сам же меняет нашу жизнь. Он действует на основе классических когнитивных функций: естественного языка, зрения, памяти, счета, анализа, сравнения, повторения, перевода, игры и так далее.

Пересечение искусственного интеллекта с когнитивной психологией и когнитивной наукой объясняет «человеческую» часть ИИ — а, следовательно, человеческую часть робота R2-D2 — и черпает вдохновение из биологического интеллекта и механизмов развития наших знаний.

Можно отметить, что обучение путем наблюдения является общим для людей и машин, и мы дополняем друг друга. Контролируемое машинное обучение позволяет ИИ учиться и даже совершенствоваться за счет человеческих ошибок и обратной связи, чтобы лучше сортировать входные данные. Такой подход повышает точность и надежность данных на выходе. Отметим также, что ИИ способен обучаться без контроля. Это автономное обучение, при котором не требуется сигнал ошибки для коррекции. В случае человека мы обращаемся к закону Хебба, чтобы понять, как работают когнитивные функции. Например, как работает память — нейроны активируются вместе и соединяются друг с другом, образуя связи, которые со временем становятся прочнее.

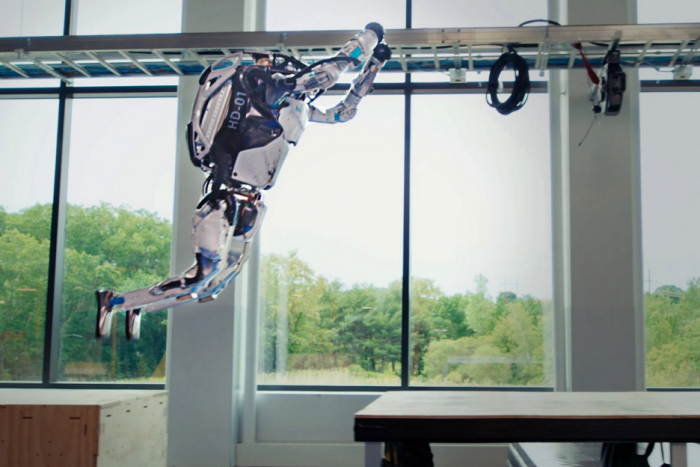

Робот Boston Dynamics

Робот Boston Dynamics

Также упомянем обучение с помощью подкрепления, которое относится к обучению с помощью вознаграждения и наказания (метод пряника и кнута). Опять же, люди и умные машины близки. Награда связана с целью, заданной программистами. ИИ предпринимает множество попыток и изучает все возможности для достижения этой цели — и, следовательно, награды. Наконец, глубокое обучение также является типом обучения. Этот тип вдохновлен работой человеческого мозга и поэтому использует искусственные нейронные сети и алгоритмы. Технология нейронных сетей в сочетании с «большими данными» уже развернута во многих секторах, включая оборонный, промышленный и медицинский.

Не бывает искусственного без человеческого

На данном этапе развития ИИ важно выделить 4 общих момента между искусственным и человеческим интеллектом:

- оба опираются на знания, получаемые от окружающих

- оба учитывают прошлый опыт

- производят выводы в зависимости от входных данных

- сомневаются и выявляют когнитивные искажения

Возвращаясь к R2-D2 и его «человечности», отметим, что этические ограничения также присутствуют в так называемых «умных» машинах. Машина не может — не должна? – в одиночестве принимать решение о смерти человека, например. Мы считаем нежелательным, чтобы машина могла стать полностью автономным оружием.

Поэтому люди не должны исключать себя из процессов принятия решений машинами. Мы должны сохранять контроль, особенно когда используется специфический язык эмоций, ненависти, юмора, иронии, провокации, метафоры. В такой ситуации умная машина когда не обязательно может понять смысл слов, изображения или контекста.

Нет автономии без человеческого контроля

Человек учится приспосабливаться и выживать. Он узнает от родителей и окружающих первые слова в четко определенных контекстах, после чего пытается их понять и контекстуализировать. «Умная» машина учится воспроизводить товар или услугу. С первых экспериментов в 1955 году она опирается на обширную базу данных, значение которой она не понимает. Цель — попытаться идентифицировать корреляции, охарактеризовать сходство и попытаться сформировать ответ на языке, понятном человеку или другой машине. Понимание, решения и обратная связь искусственного интеллекта носят статистический, логический и математический характер. Именно поэтому Европейская комиссия недавно опубликовала «согласованные правила в области искусственного интеллекта», регулирующие использование ИИ.

Тем не менее, в экстремальных ситуациях часто сложно объяснить решения, принимаемые ИИ. Черный ящик, который предлагает нам выходные данные, не в состоянии объяснить предшествующую логику — за исключением логики, подобной логике Хоара.

Парадокс R2-D2, подверженного ошибкам больше, чем следовало бы машине, это хорошая новость. Это доказательство того, что за невидимым сценарием действительно стоит человек!

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России