Принципиально новый метод позволяет тренировать ИИ практически без данных

Обучение «менее чем с одной» попытки помогает модели идентифицировать больше объектов, чем количество примеров, на которых она тренировалась. Как правило, машинное обучение требует множества примеров. Чтобы ИИ-модель научилась распознавать лошадь, вам потребуется показать ей тысячи изображений лошадей. Поэтому технология настолько вычислительно затратна и сильно отличается от человеческого обучения. Ребенку зачастую нужно увидеть всего несколько примеров объекта, или даже один, чтобы научиться распознавать его на всю жизнь.

На самом деле, детям иногда не нужны никакие примеры, чтобы идентифицировать что-нибудь. Покажите фотографии лошади и носорога, скажите, что единорог — это нечто среднее, и они узнают мифическое создание в книжке с картинками, как только увидят его в первый раз.

Теперь исследование из Университета Уотерлу в Онтарио предполагает, что ИИ-модели тоже могут это делать — процесс, который исследователи называют обучением «менее чем с одной» попытки. Иными словами, ИИ-модель может четко распознавать больше объектов, чем число примеров, на которых она тренировалась. Это может иметь решающее значение для области, которая становится все дороже и недоступнее по мере того, как растут используемые наборы данных.

Ммм… Не совсем! MS TECH / PIXABAY

Ммм… Не совсем! MS TECH / PIXABAY

Как работает обучение «менее чем с одной» попытки

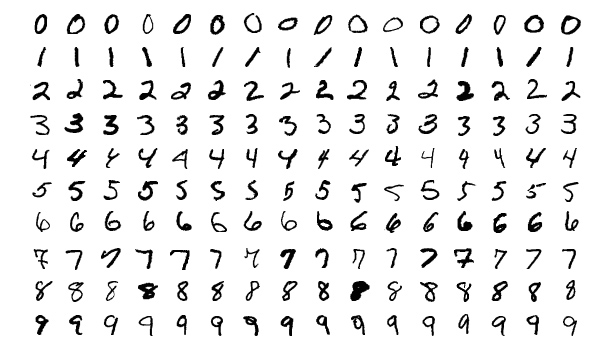

Исследователи впервые продемонстрировали эту идею, экспериментируя с популярным набором данных для тренировки компьютерного зрения, известным как MNIST. MNIST содержит 60 000 изображений рукописных цифр от 0 до 9, и набор часто используют для проверки новых идей в этой области.

В предыдущей статье исследователи из Массачусетского технологического института представили метод «дистилляции» гигантских наборов данных в маленькие. В качестве подтверждения концепции они сжали MNIST до 10 изображений. Изображения не были выбраны из исходного набора данных. Их тщательно спроектировали и оптимизировали, чтобы они содержали объем информации, эквивалентный объему полного набора. В результате, при обучении на 10 этих изображениях ИИ-модель достигает почти такой же точности, как и обученная на всем наборе MNIST.

Примеры изображений из набора MNIST. WIKIMEDIA

Примеры изображений из набора MNIST. WIKIMEDIA

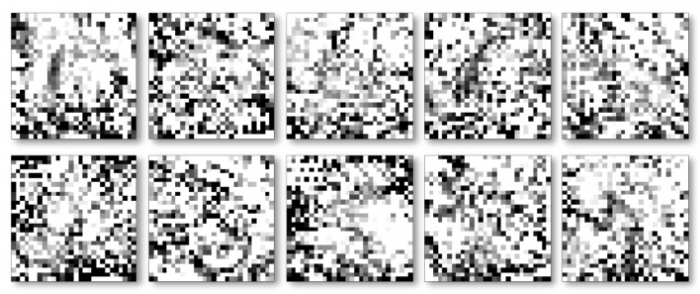

10 изображенных, «дистиллированных» из MNIST, могут обучить ИИ-модель достигать 94-процентной точности распознавания рукописных цифр. Тунчжоу Ван и др.

10 изображенных, «дистиллированных» из MNIST, могут обучить ИИ-модель достигать 94-процентной точности распознавания рукописных цифр. Тунчжоу Ван и др.

Исследователи из университета Уотрелу хотели продолжить процесс дистилляции. Если возможно уменьшить 60 000 изображений до 10, почему бы не сжать их до пяти? Фокус, как они поняли, заключался в том, чтобы смешивать несколько цифр в одном изображении, а затем передавать их в модель ИИ с так называемыми гибридными, или «мягкими», метками. (Представьте лошадь и носорога, которым придали черты единорога).

«Подумайте о цифре 3, она похожа на цифру 8, но не на цифру 7, — говорит Илья Сухолуцкий, аспирант Уотерлу и главный автор статьи. — Мягкие метки пытаются запечатлеть эти общие черты. Поэтому вместо того, чтобы сказать машине: «Это изображение — цифра 3», мы говорим: «Это изображение — на 60% цифра 3, на 30% цифра 8 и на 10% цифра 0»».

Ограничения нового метода обучения

После того как исследователи успешно использовали «мягкие» метки для достижения адаптации MNIST под метод обучения «менее чем с одной» попытки, то начали задаваться вопросом, насколько далеко может зайти идея. Существует ли ограничение на количество категорий, которые ИИ-модель может научиться определять на крошечном количестве примеров?

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России