Путь искусственного интеллекта от фантастической идеи к научной отрасли

Идея искусственного интеллекта давно волнует человечество. Автоматонам уделялось много внимания в мифах Древней Греции, и наиболее известным примером является искусственная женщина Пандора, созданная Зевсом. В еврейской культуре встречаются мистические големы. А удивительные куклы каракури занимают важное место в японском эпосе.

В 17 веке некоторые философы размышляли над возможностью «вложить разум» в неодушевлённые предметы. Было выдвинуто множество теорий. К примеру, Рене Декарт верил в дуализм разума и тела. Его взгляды отвергали возможность механизации интеллекта.

У Лейбница были другие взгляды. Он полагал, что вся человеческая мысль может быть представлена математически с помощью элементарных символов. Для этого он предложил Characteristica Universalis, символику понятий, необходимую для описания знаний.

Искусственный интеллект и автоматоны фигурируют в художественной литературе с незапамятных времён. В качестве примера можно привести «Франкенштейн, или Современный Прометей» Мэри Шелли и «Россумские универсальные роботы» Карела Чапека. Благодаря им в 1921 году в литературе появилось слово «робот».

Это были философские предпосылки для появления ИИ. Теперь давайте поговорим о конкретных учёных и их трудах, благодаря которым искусственный интеллект из выдумки стал реальностью. Относительно конкретная и подкреплённая фактами история началась относительно недавно. Знаменитый тест Тьюринга впервые был проведён в 1950, но лишь спустя шесть лет, в 1956 году, ИИ начал формироваться как отдельная дисциплина. Давайте посмотрим, как это было.

Первые шаги

Количество научных работ, связанных с искусственным интеллектом, резко выросло в 1950–60-х годах. Но и ранее встречались исследования, затрагивающие данную тему. Бертран Рассел и Альфред Норт Уайтхед опубликовали «Принципы математики» в 1913 году. Примерно в то же время Джордж Буль выдвинул свои законы мысли. Так были заложены основы математической логики.

Возможно, всё началось в тот момент, когда непонятный 15-летний мальчишка ворвался в кабинет Рудольфа Карнапа. Карнап тогда уже стал влиятельным философом и преподавал в Чикагском университете. Он опубликовал «Логический синтаксис языка». Мальчик пришел без разрешения, и указал на ошибки в этой работе. Рудольф был потрясен. Посетитель был необычным. Кроме того, он даже не представился, и сразу убежал. После нескольких месяцев поисков Рудольф наконец нашел своего визитёра в одном из местных университетов. Им оказался Уолтер Гарри Питтс.

За три года до этого (да-да, в 12 лет) Уолтер написал письмо Бертрану Расселу, указав на проблемы, найденные в вышеупомянутых «Принципах». Рассел оказался настолько впечатлён, что пригласил мальчика учиться в аспирантуре Кембриджского университета в Великобритании. Уолтер, хотя и рос в неблагополучной семье, не решился на переезд из Детройта. Однако, когда Рассел приехал с лекциями в Чикаго, Питтс сбежал из дома, чтобы учиться у него. Студентом Чикагского университета он не стал, но прилежно ходил на лекции. (Жизнь Уолтера Питтса вообще очень яркая и интересная, несмотря на малую её продолжительность. Рекомендую почитать о нём самостоятельно — прим. переводчика).

В 1942 году Уолтер Питтс встретился с Уорреном МакКаллоком. Маккаллок пригласил Питтса остаться у него дома. Они были убеждены в правильности теории Лейбница, которая предполагала возможность «механизации» человеческой мысли. И пытались создать модель для нейробиологии нервной системы человека. Они опубликовали свою основную статью об этом же в 1943 году, назвав её «Логическое исчисление идей, относящихся к нервной активности». Этот документ внёс неоценимый вклад в область искусственного интеллекта. Учёные предложили простую модель, известную как математический нейрон Маккаллока — Питтса . Она до сих пор изучается на курсах машинного обучения. Идеи, которые предложили учёные, являются основой почти всех современных ИИ.

Уоррен МакКаллок и Уолтер Питтс

Уоррен МакКаллок и Уолтер Питтс

Кибернетика Норберта Вейнера и теория информации Клода Шеннона были опубликованы в 1948 году. Кибернетика — это исследование «управления и коммуникации в живом организме и в машине». Теория информации — это измерение количества информации, её хранения и передачи. Обе работы сильно повлияли на сферу ИИ.

Кибернетика обеспечила непосредственное исследование биологического и механического интеллекта. А теория информации повлияла на базовую математику (essential mathematics).

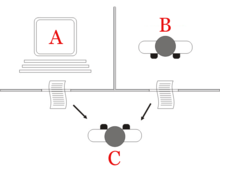

Спустя пару лет Алан Тьюринг выступил с тестом Тьюринга. Он описал способ определения, является ли машина «умной». Упрощённо тест выглядит следующим образом: человек общается с одним компьютером и одним человеком. На основании их ответов на вопросы он должен определить, с кем он разговаривает: с человеком или компьютерной программой. Задача компьютерной программы — ввести человека в заблуждение, заставив сделать неверный выбор».

Хотя тест Тьюринга слишком ограничен для тестирования современных «умных» систем, в то время это был настоящий прорыв. Имя Алана Тьюринга попало в прессу, сделав отрасль более популярной.

Тест Тьюринга

Тест Тьюринга

В 1956 в Дартмуте прошла конференция, посвящённая теме изучения концепций «механизации» интеллекта. Позже участники этой конференции станут выдающимися личностями в области ИИ. Наиболее известным был Марвин Мински, который в 1951 году создал первую машину нейронных сетей, SNARC. Он станет самым известным именем в мире искусственного интеллекта на последующие десятилетия.

Присутствовал на конференции и Клод Шеннон. А будущий нобелевский лауреат Герберт А. Саймон и Аллен Ньюэлл дебютировали со своей «Логикой-теоретикой». Впоследствии он решит 38 из первых 52 теорем в «Принципах математики» Рассела. Джон Маккарти — также один из пионеров искусственного интеллекта — придумал название «Искусственный интеллект». Участники согласились с этим термином. Это было рождение ИИ.

Развитие отрасли (1956–1974)

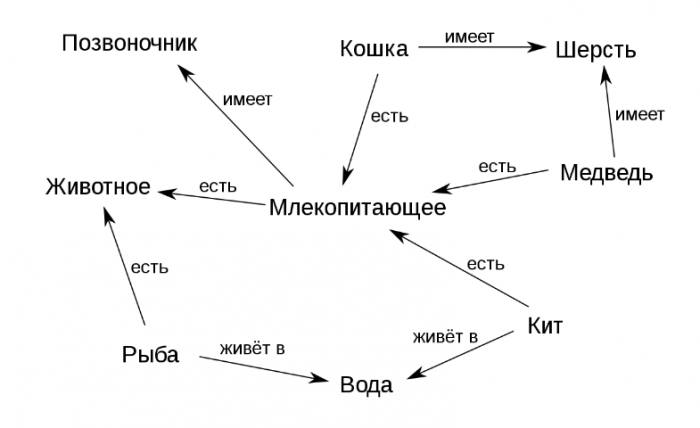

Семантическая сеть

Семантическая сеть

Благодаря этому удачному лейблу интерес к ИИ вырос, появилось множество интересных разработок. В 1959 году Ньюэлл и Саймон создали «Решатель общих проблем», который теоретически мог решить любую формализованную проблему. А Джеймс Слэйгл создал SAINT (Symbical Automatic INTegrator) эвристическую программу, решавшую проблемы символической интеграции в исчислении. Эти программы были впечатляющими.

После создания теста Тьюринга естественность языка стала важной областью ИИ. Программа Даниэля Боброу STUDENT смогла решить проблемы со словом в средней школе. Чуть позже появилось понятие семантической сети — карты различных понятий и отношений между ними (как на рисунке). Несколько успешных программ были построены на этой сети. В 1966 году Джозеф Вайзенбаум создал ELIZA. Виртуальный собеседник мог вести реалистичные беседы с людьми.

В связи со столь активным развитием отрасли ИИ учёные выдвигали крайне смелые заявления:

- Ньюэлл и Саймон, 1958 год: « Через 10 лет цифровой компьютер станет чемпионом мира по шахматам». И «в течение 10 лет цифровой компьютер обнаружит и докажет важную новую математическую теорему».

- Саймон Г.А., 1965 г.: «Машины будут способны в течение 20 лет выполнять любую работу, которую может выполнять человек».

- Марвин Мински, 1967 г.: «Через поколение… проблема создания« искусственного интеллекта »будет существенно решена».

- Марвин Мински, 1970 г.: «Через три-восемь лет у нас будет машина с общим интеллектом обычного человека».

Так или иначе, в отрасль пришли деньги. Управление перспективных исследовательских проектов (ARPA, позже переименованное в DARPA) выделило команде MIT 2,2 миллиона долларов. Тогдашний президент DARPA решил, что они должны «финансировать людей, а не проекты», и создал свободную исследовательскую культуру. Это позволило исследователям осуществлять любые проекты, которые они считали правильными.

Временное похолодание (1974–1980)

В 1969 году Марвин Мински и Сеймур Паперт опубликовали свою книгу «Перцептроны» . В ней они показали принципиальные ограничения перцептронов и выдвинули на первый план неспособность персептронов управлять элементарной схемой XOR. Это привело к смещению интереса исследователей искусственного интеллекта в противоположную от нейросетей область символьных вычислений.

Альтернативный подход символьного ИИ получил взрывной рост. Но этот подход не дал каких-либо существенных результатов. В 1970-х годах стало ясно, что исследователи ИИ чрезмерно оптимистичны в отношении ИИ. Цели, которые они обещали, ещё не были достигнуты и их достижение казалось делом весьма отдалённого будущего.

Исследователи поняли, что упираются в стену. ИИ применялся к простым задачам. Но реальные сценарии оказались слишком сложными для этих систем. Число возможностей, которые алгоритмы должны были исследовать, получалось астрономическим. Это привело к проблеме комбинаторного взрыва. А затем возник классический вопрос «как сделать компьютер умным». Это была проблема здравого смысла.

Всё этор привело к тому, что инвесторы разочаровались в технологии. Финансирование ИИ, таким образом, исчезло, а исследования прекратились. DARPA тоже больше не могла поддерживать хакерскую культуру исследований из-за изменений в законодательстве. Спонсоры заморозили финансирование исследований в области искусственного интеллекта. Поэтому период 1974–1980 гг. называют «зимой ИИ».

Возрождение

В 1981 году правительство Японии начало серьёзно вкладываться в исследования в области искусственного интеллекта. Страна выделила 850 млн долларов на проект «Компьютер пятого поколения». Он был нацелен на развитие ИИ. Предполагаемые компьютеры должны были общаться, переводить другие языки, распознавать картинки. Ожидалось, что компьютеры станут базой для создания устройств, способных имитировать мышление.

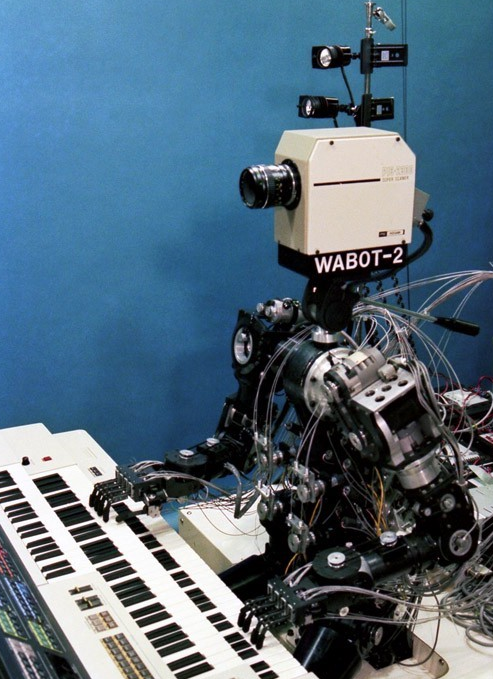

Wabot-2

Wabot-2

Исследования в Японии казались многообещающими. В 1980 году в университете Васэда был разработан робот Wabot-2. Он мог общаться с людьми, читать музыкальные партитуры и играть на электронном органе. Успех японцев заставил правительства других стран и частный бизнес снова обратить свой взгляд в сторону ИИ.

В этот момент возник вопрос коннекционизма. В 1982 году Хопфилд создал новую форму нейронной сети, которая способна изучать и обрабатывать информацию. Джеффри Хинтон и Дэвид Румелхарт популяризировали авторазличие в обратном режиме. Эта технология была феноменальной и остается жизненно важной в машинном обучении и по сей день.

ИИ получил коммерческий успех в виде «экспертных систем». Эти системы обладали глубоким знанием конкретной темы. Университет Карнеги — Меллона (CMU) в 1980 году выпустил экспертную систему под названием XCON. Она использовалась в корпорации Digital Equipment. До 1986 года компания ежегодно экономила 40 млн долларов.

Вторая зима

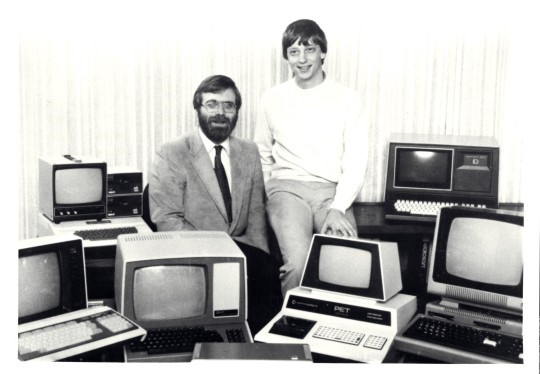

ПК революция изменила курс развития ИИ

ПК революция изменила курс развития ИИ

В конце 1980-х успешный рост отрасли ИИ омрачила «компьютерная революция». Apple и IBM производили все более и более мощные компьютеры одновременно. Настольные компьютеры стали дешевле и мощнее, чем Lisp-машины на базе искусственного интеллекта. Целая индустрия стоимостью полмиллиарда долларов была разрушена за одну ночь. Успехи ИИ в таких экспертных системах, как машина XCON, оказались слишком дорогими.

Возникли проблемы с экспертными системами. Они не могли учиться. Они были «хрупкими» (то есть могли совершать серьёзные ошибки, если им давали необычные данные). Практическая область применения экспертных систем стала ограниченной. Новое руководство DARPA решило, что ИИ не является «следующей волной». И перенаправило инвестиции на проекты, которые, с их точки зрения, должны были принести немедленные результаты.

К 1991 году цели компьютерного проекта Японии так и не были достигнуты. Учёные недооценили те трудности, с которыми им пришлось столкнуться. Свыше 300 ИИ-компаний закрылись обанкротились или были куплены к концу 1993 года. Это был фактически конец первой волны коммерческого использования искусственного интеллекта.

Свежая струя

Когда отголоски компьютерной революции начали затихать, у людей появилась возможность пользоваться большими вычислительными мощностями. С повсеместным распространением компьютеров стало расти и количество разнообразных баз данных. Это всё было очень здорово и с точки зрения развития ИИ.

Новые технологии решали проблемы и снимали барьеры, мешавшие учёным. Пользуясь возрастающей вычислительной мощностью, исследователи раздвигали границы возможного. Из баз данных, ставших Big Data, удавалось извлечь всё больше и больше знаний. Возможности практического применения ИИ стали более очевидными.

Новая концепция под названием «интеллектуальный агент» утвердилась в 1990-х годах. Интеллектуальный агент (ИА) — это система, которая самостоятельно выполняет задание, выданное пользователем, в течение длительных промежутков времени. Появилась надежда, что однажды мы сможем научить ИА взаимодействовать друг с другом. Это привело бы к созданию универсальных и более «умных» систем.

В сообществе ИИ бродили разные мнения об использовании математики в сфере искусственного интеллекта. Одни считали, что интеллект слишком сложен для того, чтобы описывать его математическими символами. По их мнению, люди редко руководствуются логикой при принятии решений. Их оппоненты возражали, что логические цепочки — это путь вперёд.

Г. Каспаров играет с Deep Blue

Г. Каспаров играет с Deep Blue

Очень скоро, в 1997 году, суперкомпьютер IBM Deep Blue победил Гарри Каспарова. В тот момент Каспаров был чемпионом мира по шахматам. То, что, по словам Ньюэлла и Саймона, должно было произойти к 1968 году, наконец-то свершилось в 1997 году.

Современные шахматные компьютеры намного сильнее любого человека. Самый высокий рейтинг Эло, когда-либо достигнутый человеком, составляет 2882. Для компьютеров вполне обычный показатель — 3000 Эло. Самый высокий показатель за всю историю был более 3350.

В 2005 году Стэнфорд разработал робота для автономного вождения. Он выиграл DARPA Grand Challenge, проехав 131 милю (211 км) по неизученной пустынной тропе.

Jeopardy

Jeopardy

В феврале 2011 года IBM решила протестировать свой IBM Watson в викторине «Jeopardy». Компьютер смог победить двух величайших чемпионов Jeopardy со значительным отрывом.

С лавинообразным развитием интернета и соцсетей росло и количество информации. ИТ-компаниям необходимо было что-то делать с получаемыми данными. И применение ИИ стало необходимостью, а не развлечением.

Теперь Google сортирует выдачу, используя системы машинного обучения (Machine Learning). YouTube подбирает рекомендуемые видео с помощью алгоритмов ML, по той же схеме рекомендует товары Amazon. Новостная лента Facebook генерируется «умным» компьютером. И даже Tinder находит людей, используя алгоритмы ML.

Благодаря компьютерной революции ИИ-технологии стали нашими незаменимыми помощниками. И теперь человечество смотрит вперёд, ожидая создание супермашин. И хотя последствия достижений искусственного интеллекта порой спорны, дальнейшее развитие этой технологии неизбежно.

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России